如何在 Magento 2 中配置 Robots.txt

如您所知,配置robot.txt对于任何致力于网站搜索引擎优化的网站都很重要。特别是,当您将站点地图配置为允许搜索引擎为您的商店编制索引时,有必要向网络爬虫提供 robots.txt 文件中的说明,以避免索引不允许的站点。位于 Magento 安装根目录中的 robots.txt 文件指示 Google、Yahoo、Bing 等搜索引擎可以轻松识别和跟踪。在这篇文章中,我将介绍配置robot.txt 文件的指南,以便它与您的站点一起工作。

Magento 2 中的 Robots.txt 是什么?

robots.txt 文件指示网络爬虫知道在哪里索引您的网站以及在哪里跳过。定义这个网站机器人 - 网站爬虫关系将帮助您优化您网站的排名。有时您需要它来识别和避免索引特定部分,这可以通过配置来完成。您可以决定使用默认设置或为每个搜索引擎设置自定义说明。

配置 Magento 2 robots.txt 文件的步骤

请按照此分步指南在 Magento 2 中配置您的 robots.txt 文件:

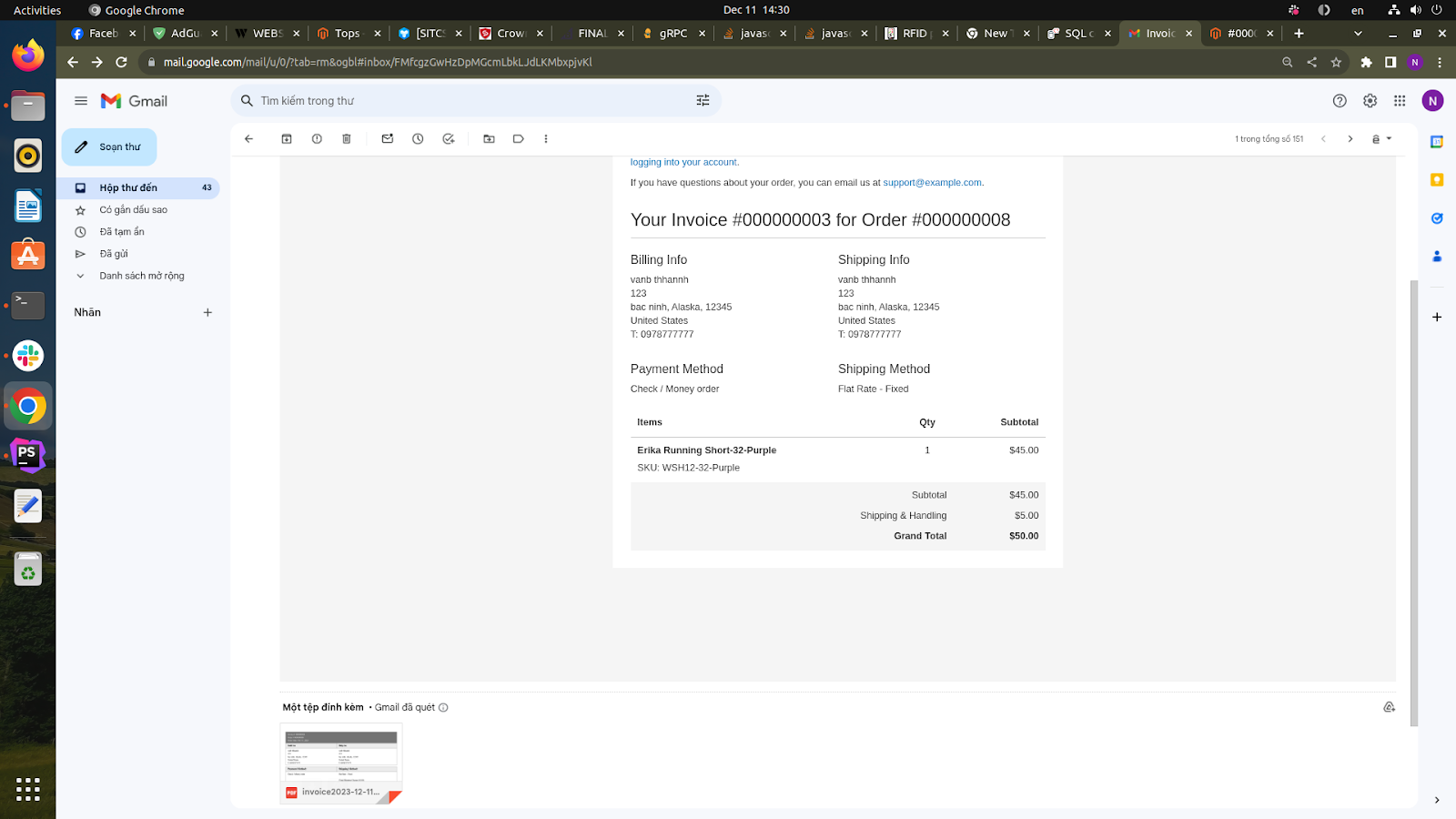

- 在管理面板上,单击

Stores。在该Settings部分中,选择Configuration。 Design在General左侧面板中选择- 打开该

Search Engine Robots部分,然后继续执行以下操作:- 在

Default Robots中,选择以下选项之一:- INDEX, FOLLOW

- NOINDEX, FOLLOW

- INDEX, NOFOLLOW

- INDEX, NOFOLLOW

- 如果需要,在该

Edit Custom instruction of robots.txt File字段中输入自定义说明。 - 如果您需要恢复默认说明,请在该

Reset to Defaults字段中单击按钮。Reset to Default

- 在

- 完成后,单击

Save Config。

Magento 2 Robots.txt 示例

您还可以通过设置自定义说明来隐藏您的网页,使其对网站爬虫隐藏,如下所示:

- 允许完全访问

User-agent:*

Disallow:

- 禁止访问所有文件夹

User-agent:*

Disallow: /

更多 Robots.txt 示例

从文件夹中阻止 Google bot

User-agent: Googlebot

Disallow: /subfolder/

从页面中阻止 Google bot

User-agent: Googlebot

Disallow: /subfolder/page-url.html常见的网络爬虫(机器人)

以下是互联网上的一些常见机器人。

User-agent: Googlebot

User-agent: Googlebot-Image/1.0

User-agent: Googlebot-Video/1.0

User-agent: Bingbot

User-agent: Slurp # Yahoo

User-agent: DuckDuckBot

User-agent: Baiduspider

User-agent: YandexBot

User-agent: facebot # Facebook

User-agent: ia_archiver # Alexa

版权声明:本站内容源自互联网,如有内容侵犯了你的权益,请联系删除相关内容。

邮件群发-邮件群发软件|邮件批量发送工具|群发邮件平台|批量邮箱发送系统公司

邮件群发-邮件群发软件|邮件批量发送工具|群发邮件平台|批量邮箱发送系统公司